- A Kind of Magic

- Posts

- Prompter efficacement (Partie 1)

Prompter efficacement (Partie 1)

À la une : Manus AI : L’agent autonome chinois qui fait parler

Au menu d’aujourd’hui :

🎓 Prompter efficacement (Partie 1)

🗞️ À la une : Manus AI : L’agent autonome chinois qui fait parler

📮 5 autres news en bref

💎 4 ressources de la semaine

Dans cette newsletter et la suivante je te partage mes meilleurs conseils pour écrire des prompts efficaces.

🎓 Prompter efficacement (Partie 1)

1️⃣ Écris tes prompts en anglais (même si ton besoin est en français)

Tu as peut-être déjà vu passer ce tweet viral d’Andrej Karpathy (cofondateur d’OpenAI), publié juste après le lancement de ChatGPT en novembre 2022 :

En réalité, ce tweet nous dit deux choses essentielles :

Le prompt engineering, discipline utilisant le langage naturel (par opposition au langage informatique), est né.

L’anglais est aujourd’hui la langue privilégiée pour interagir avec les modèles de langage (LLMs).

Mais pourquoi précisément l’anglais ?

Parce que les LLMs, comme ChatGPT, sont majoritairement entraînés sur des données en anglais (jusqu’à 90% pour GPT-3). En conséquence, ces modèles comprennent mieux les nuances, la complexité et les subtilités en anglais.

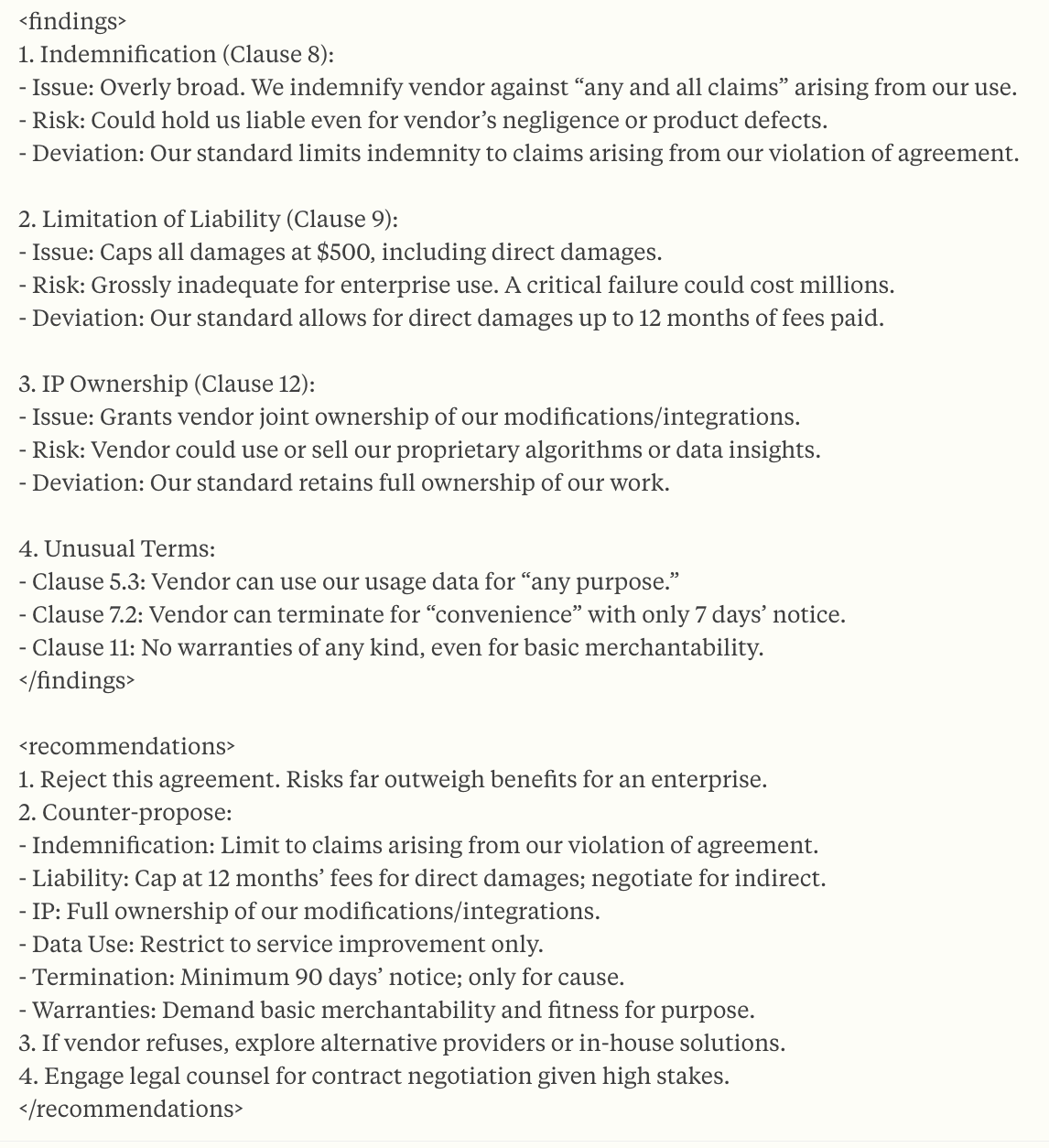

Ce tableau montre la répartition en % de chaque langue dans les corpus de CommonCrawl (crawl d’internet open source beaucoup utilisé pour l’entraînement des modèles)

À l’inverse de l’anglais, pour certaines langues “rares” comme l’arabe (en termes de représentation dans les corpus d’entraînement), les LLMs manquent de nuances et de connaissances culturelles.

C’est pourquoi on a vu se développer des exemples de LLMs entraînés sur des datasets spécialisés.

While larger, general-purpose models are often proficient in several languages, they lack linguistic nuances, cultural background, and in-depth regional knowledge required to serve use cases with strong regional context.

C’est dans ce contexte que Mistral a récemment lancé Mistral Saba, un modèle spécialement développé pour le Moyen-Orient et l’Asie du Sud.

Le modèle est un poil moins performant sur l’anglais mais plus performant sur tous les benchmarks en langue arabe.

Bon d’accord, les LLMs sont plus “habitués” à l’anglais parce qu’ils ont fait leur entraînement sur plus de texte en anglais.

Mais à quel point ça impacte la performance des résultats si on leur parle en français ?

Réponse courte : ça l’impacte et il vaut mieux prompter en anglais.

Une étude (2023) de l'université de l’Oregon a mesuré la performance de ChatGPT selon la langue utilisée pour les prompts. La conclusion est sans appel : les performances du modèle sont systématiquement meilleures lorsqu'on le prompt en anglais.

The most important findings from our experiment results is that ChatGPT exhibits significantly worse performance than state-of-the-art supervised models for most of considered NLP tasks in different languages.

L’une des compétences testées dans le papier est la Natural Language Inference (ou NLI). Concrètement c’est la capacité d’un LLM à comprendre le lien entre 2 phrases : entailment (“implication" en français, si une phrase est vraie, l’autre aussi) / aucun lien / contradiction

Voici un exemple tiré d’un dataset de XNLI (pour Cross-Language Natural Language Inference)

On observe que lorsqu’on demande à ChatGPT de faire le lien entre 2 phrases, la performance est significativement moins forte lorsque le prompt est dans la langue d’origine des phrases par rapport à un prompt en anglais.

Concrètement sur du NLI, des instructions en anglais donneront une meilleure précision que des instructions en français, y compris lorsque le texte à analyser est en français !

💡 Conseil pratique : Toujours utiliser de l’anglais dans les instructions, quitte à demander à écrire en français ou traduire le résultat obtenu.

2️⃣ Donne un rôle (ou persona) au LLM

Même si cela peut sembler un peu artificiel, donner explicitement un rôle à l’IA améliore considérablement la pertinence et la précision de ses réponses.

Pourquoi ?

Parce que le modèle adopte automatiquement le style, le vocabulaire et les nuances attendues pour ce rôle précis.

Une image vaut mieux que 1000 mots. Voici un exemple tiré de la documentation d’Anthropic, la société derrière Claude.

Si tu demandes simplement une analyse financière sur un jeu de données, tu obtiendras un résultat correct mais limité.

Prompt

Réponse

En revanche, si tu précises : « Tu es CFO d’une startup B2B en forte croissance, réalise une analyse approfondie des résultats trimestriels » dans le prompt.

Le modèle produit une réponse bien plus détaillée, structurée et pertinente.

En résumé, préciser un rôle permet de :

Augmenter la précision et la spécialisation des réponses.

Personnaliser le ton et le format selon tes attentes.

Concentrer le modèle sur les aspects essentiels de ta tâche.

💡 Conseil pratique : Donne toujours un rôle clair au modèle pour obtenir des réponses optimisées.

3️⃣ Structure ton prompt avec des délimiteurs clairs

Les délimiteurs ce sont des éléments qui permettent de structurer un texte en plusieurs parties, il y a par exemple :

les balises XML → <data> tu mets les données ici </data>

les triples guillemets → “““ texte à analyser “““

le markdown → # Role

Tous les fournisseurs de LLMs (y compris OpenAI et Anthropic) recommandent d’utiliser des délimiteurs pour améliorer la performance des prompts.

Pourquoi ?

Parce qu’ils aident le modèle à comprendre précisément chaque partie du prompt sans ambiguïté.

Chez Anthropic, ils recommandent spécifiquement d’utiliser des balises XML. Là aussi ils donnent des exemples avant / après très parlants.

Exemple sans balises XML

Prompt

Réponse

Le même exemple mais avec des délimiteurs dans le prompt

Prompt

Réponse

Chez OpenAI, ils sont moins restrictifs et mentionnent plusieurs types de délimiteurs : triples guillemets, balises XML, ou markdown.

Personnellement j’ai pris l’habitude de structurer mes prompts avec du markdown, voilà un squelette basique que tu peux copier-coller.

# Role

En markdown voilà comment mettre du texte en **gras**

# Context

Tu peux aussi utiliser des bullets points avec des *

* bp 1

* bp 2

# Task

# Exemples

## Exemple 1

## Exemple 2

# Format

# Important notes

💡 Conseil pratique : Choisis un type de délimiteurs qui te convient et utilise-le dans tes prompts.

C’est tout pour aujourd’hui sur le prompt engineering, on continue la semaine prochaine avec plus de tips pour prompter efficacement !

🗞️ À la une

Une startup chinoise vient de dévoiler Manus, présenté comme le premier agent d'IA totalement autonome au monde, capable d'effectuer des tâches complexes comme l'analyse de CV, la recherche immobilière, la navigation web et la programmation sans intervention humaine.

Les performances de Manus surpasseraient celles de ChatGPT et Gemini sur le benchmark GAIA, bien que certains experts restent sceptiques quant à ces affirmations. L'accès est actuellement limité sur invitation, avec une promesse d'open-source des modèles plus tard dans l'année.

📮 Autres news en bref

Mistral lance une API OCR avec 94,89% de précision et le traitement de 2000 pages par minute.

OpenAI lance de nouveaux outils permettant aux entreprises de créer leurs propres agents IA avec une API Responses améliorée.

Google déploie un mode IA dans Search permettant des conversations suivies avec liens web pour les abonnés Google One AI Premium.

McDonald's déploie l'IA dans ses 43 000 restaurants avec Google Cloud pour optimiser les opérations.

OpenAI prépare des agents IA spécialisés avec des abonnements de 2 000 à 20 000 $ par mois.

💎 Ressources

Article intéressant sur l’impact de l’IA sur l’esprit critique.

Une étude d'OpenAI révèle que la suppression des "mauvaises pensées" des IA peut avoir l'effet inverse de celui recherché.

Article expliquant pourquoi l'IA n'apprend pas vraiment.

Analyse approfondie de l'évolution des CAPTCHA face à l'IA.

🎤 À toi le micro

Voilà, c’est la fin de cette 18ème édition de A Kind of Magic, j’espère qu’elle t’a été utile.

N’hésite pas à la partager si c’était le cas.

Dispo pour échanger en réponse à cet e-mail ou sur Linkedin.

À jeudi !

Jean-Charles